Por que alinhar IA aos nossos valores pode ser mais difícil do que pensamos

Podemos impedir uma IA desonesta ensinando-lhe ética? Isso pode ser mais fácil dizer do que fazer.

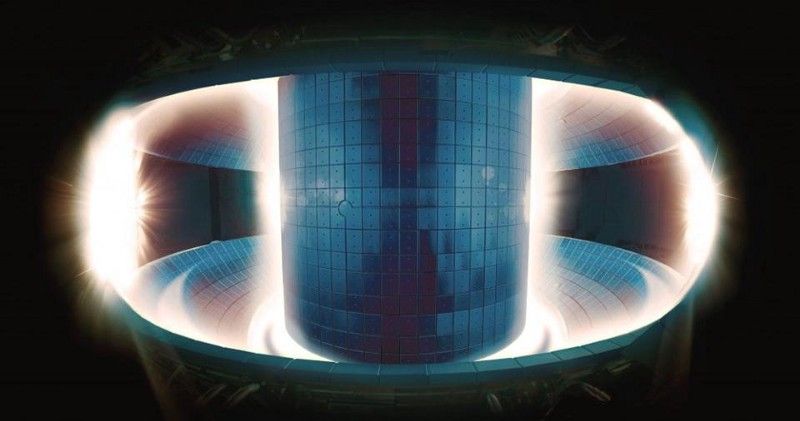

Supercomputador de aparência estranha.

Crédito: STR / JIJI PRESS / AFP via Getty Images- Uma maneira de evitar que a IA se torne desonesta é ensinando a ética a nossas máquinas para que não causem problemas.

- As questões sobre o que devemos, ou mesmo podemos ensinar aos computadores, permanecem desconhecidas.

- A maneira como escolhemos os valores que a inteligência artificial segue pode ser a coisa mais importante.

Muitos cientistas, filósofos e escritores de ficção científica se perguntaram como evitar que uma IA super-humana em potencial destrua todos nós. Embora a resposta óbvia de 'desligue-o se tentar matá-lo' tenha muitos defensores (e trabalhou em a COISA 9000 ), não é muito difícil imaginar que uma máquina suficientemente avançada seria capaz de impedi-lo de fazer isso. Alternativamente, uma IA muito poderosa pode ser capaz de tomar decisões muito rapidamente para que os humanos as revisem quanto à correção ética ou para corrigir os danos que causam.

A questão de impedir que uma IA potencialmente sobre-humana se torne desonesta e machuque as pessoas é chamada de 'problema de controle', e há muitas soluções potenciais para ele. Um dos mais frequentemente discutidos é ' alinhamento 'e envolve a sincronização da IA com os valores humanos, objetivos e padrões éticos. A ideia é que uma inteligência artificial projetada com o sistema moral adequado não agiria de forma prejudicial aos seres humanos em primeiro lugar.

Porém, com essa solução, o diabo está nos detalhes. Que tipo de ética devemos ensinar à máquina, que tipo de ética posso fazemos uma máquina seguir, e quem responde a essas perguntas?

Iason Gabriel considera essas questões em seu novo ensaio, ' Inteligência Artificial, Valores e Alinhamento. 'Ele aborda esses problemas enquanto aponta que respondê-los definitivamente é mais complicado do que parece.

Que efeito o modo como construímos a máquina tem sobre a ética que a máquina pode seguir?

Os humanos são realmente bons em explicar problemas éticos e discutir soluções potenciais. Alguns de nós são muito bons em ensinar sistemas éticos inteiros para outras pessoas. No entanto, tendemos a fazer isso usando linguagem em vez de código. Também ensinamos pessoas com capacidades de aprendizagem semelhantes a nós, em vez de uma máquina com habilidades diferentes. Mudar de pessoas para máquinas pode apresentar algumas limitações.

Muitos métodos diferentes de aprendizado de máquina podem ser aplicados à teoria ética. O problema é que eles podem revelar-se muito capazes de absorver uma postura moral e totalmente incapazes de lidar com outra.

Aprendizagem por reforço (RL) é uma maneira de ensinar uma máquina a fazer algo fazendo com que ela maximize um sinal de recompensa. Por meio de tentativa e erro, a máquina é finalmente capaz de aprender como obter o máximo de recompensa possível de forma eficiente. Com sua tendência embutida de maximizar o que é definido como bom, esse sistema claramente se presta ao utilitarismo, com seu objetivo de maximizar a felicidade total, e outros sistemas éticos consequencialistas. Ainda não se sabe como usá-lo para ensinar com eficácia um sistema ético diferente.

Alternativamente, o aprendizado ou aprendizado por imitação permite que um programador dê a um computador uma longa lista de dados ou um exemplar para observar e permite que a máquina inferir valores e preferências a partir deles. Os pensadores preocupados com o problema de alinhamento freqüentemente argumentam que isso poderia ensinar a uma máquina nossas preferências e valores por meio da ação, em vez da linguagem idealizada. Exigiria apenas que mostrássemos à máquina um exemplo moral e lhe disséssemos para copiar o que ela faz. A ideia tem mais do que algumas semelhanças com Ética da virtude .

O problema de quem é um exemplo moral para outras pessoas permanece sem solução e quem, se é que devemos fazer com que os computadores tentem emular, é igualmente motivo de debate.

Ao mesmo tempo, existem algumas teorias morais que não sabemos como ensinar às máquinas. As teorias deontológicas, conhecidas por criar regras universais que se aplicam o tempo todo, normalmente contam com um agente moral para aplicar a razão à situação em que se encontram ao longo de linhas específicas. Nenhuma máquina existente atualmente é capaz de fazer isso. Mesmo a ideia mais limitada de direitos e o conceito de que eles não devem ser violados, não importa o que diga qualquer tendência de otimização, pode ser um desafio para codificar em uma máquina, dado o quão específico e claramente definido você teria que fazer esses direitos.

Depois de discutir esses problemas, Gabriel observa que:

'À luz dessas considerações, parece possível que os métodos que usamos para construir agentes artificiais podem influenciar o tipo de valores ou princípios que podemos codificar.'

Este é um problema muito real. Afinal, se você tem uma super IA, não gostaria de ensiná-la ética com a técnica de aprendizado mais adequada para como você a construiu? O que você faria se essa técnica não pudesse ensinar nada além do utilitarismo muito bem, mas você decidiu que a ética da virtude é o caminho certo a seguir?

Se os filósofos não concordam sobre como as pessoas devem agir, como vamos descobrir como um computador hiperinteligente deve funcionar?

O importante pode não ser programar uma máquina com a única teoria ética verdadeira, mas sim ter certeza de que ela está alinhada com valores e comportamentos com os quais todos podem concordar. Gabriel apresenta várias idéias sobre como decidir quais valores a IA deve seguir.

Um conjunto de valores pode ser encontrado por meio de consenso, ele argumenta. Há uma grande quantidade de sobreposições na teoria dos direitos humanos entre um corte transversal da filosofia africana, ocidental, islâmica e chinesa. Um esquema de valores, com noções como 'todos os humanos têm o direito de não serem prejudicados, não importa quanto ganho econômico possa resultar de prejudicá-los', poderia ser planejado e endossado por um grande número de pessoas de todas as culturas.

Alternativamente, os filósofos podem usar o 'Véu da Ignorância', um experimento de pensamento em que as pessoas são solicitadas a encontrar princípios de justiça que apoiariam se não soubessem quais seriam seus interesses próprios e status social em um mundo que seguisse aqueles princípios, para encontrar valores para uma IA seguir. Os valores que eles selecionam seriam, presumivelmente, aqueles que protegeriam a todos de qualquer dano que a IA pudesse causar e garantiriam que seus benefícios atingiriam a todos.

Por último, poderíamos votar os valores. Em vez de descobrir o que as pessoas endossariam sob certas circunstâncias ou com base nas filosofias que já subscrevem, as pessoas poderiam apenas votar em um conjunto de valores aos quais desejam que qualquer super AI seja vinculada.

Todas essas ideias também estão sobrecarregadas pela atual falta de uma super IA. Ainda não há uma opinião consensual sobre a ética da IA, e o debate atual não foi tão cosmopolita quanto deveria ser. Os pensadores por trás do Véu da Ignorância precisariam conhecer as características da IA que estão planejando ao criar um esquema de valores, pois dificilmente escolheriam um conjunto de valores que uma IA não foi projetada para processar de forma eficaz. Um sistema democrático enfrenta enormes dificuldades em assegurar uma 'eleição' justa e legítima para valores com os quais todos concordam que foi feita corretamente.

Apesar dessas limitações, precisaremos de uma resposta a essa pergunta mais cedo ou mais tarde; definir a quais valores devemos vincular uma IA é algo que você deseja fazer antes você tem um supercomputador que pode causar um dano tremendo se não tiver alguma variação de uma bússola moral para guiá-lo.

Embora a inteligência artificial poderosa o suficiente para operar fora do controle humano ainda esteja muito distante, o problema de como mantê-los na linha quando chegarem ainda é importante. Alinhar essas máquinas com os valores e interesses humanos por meio da ética é uma maneira possível de fazer isso, mas o problema de quais deveriam ser esses valores, como ensiná-los a uma máquina e quem decide as respostas para esses problemas permanece sem solução.

Compartilhar: